La littérature en sociologie et psychanalyse, autour du célèbre essai de Walter Benjamin « L’oeuvre d’art à l’époque de sa reproduction mécanisée » est immense. Pour notre part, en y constatant un certain défaut d’approches objectivantes, nous avons essayé de nous concentrer sur les bases épistémologiques des affirmations de Benjamin et de relever le défi des concepts servant de fond à ses spectaculaires figures de pensée en art et en communication. C’est par cette démarche, et dans le cadre d’un vaste projet d’esthétique cognitiviste, au-delà des seules extrapolations socio-politiques et communicationnelles, que nous espérons procéder à l’actualisation de la pensée benjaminienne et par là à la reformulation des critères esthétiques applicables à la situation de l’art et de la pensée actuelles.

Sur le modèle des différentes étapes historiques des techniques de production, la donnée sociologique pertinente est devenue celle qui paramètre « les masses ». Habituellement, la méthode de Benjamin consiste à cheminer depuis les procédés artistiques vers les techniques de diffusion, tout en définissant, à l’endroit de ce passage, les processus sociaux dont les masses sont à la fois acteurs, instruments et patients. Un sous-entendu marxiste préside à l’observation de ces parallélismes, le constat d’une sorte de solidarité entre différents processus socialement impératifs et inconscients, hors des volontés particulières, incarnant une intelligence du collectif. Mais « marxiste » ne veut pas dire plus que « scientiste » car un autre sous-entendu, socio-cognitif, forgé sur la base de la biologie comportementale des « populations », règle les rapports des masses à l’objet. L’usage, c’est-à-dire l’action au moyen de l’objet, façonne les masses, tout autant que les masses façonnent l’usage, c’est-à-dire agissent sur le monde au moyen des outils recelant diverses stratégies d’action.

« L’action des masses sur la réalité et de la réalité sur les masses représente un processus d’une portée illimitée, tant pour la pensée que pour la réceptivité ». Pensée et réceptivité vont de pair. La réceptivité c’est l’art. L’art est affaire de perception et non de symbolisme ou de signification des formes.

Dans sa circulation sociale, l’art est communication, et la communication est, encore une fois, non affaire de grammaire des formes, mais l’inter-perception, c’est-à-dire le processus de monstrations et de réceptions, d’exhibition de la vue et du regard. On déchiffre assez facilement l’enchaînement intellectuel figurant sous l’enseigne de la réceptivité, ainsi que son fondement, le réductionnisme biologicosociologique. Benjamin, dans son esthétique, suit la lignée de Riegl et W&Ifflin, et outrepassant son ami Adorno, se projette, par la pensée de Scholem et d’Arnheim, vers les balbutiements des sciences cognitives des années 50. Mais le domaine de la pensée précise, c’est-à-dire la théorie de la science, ne se clarifie pas, chez Benjamin, avec la même évidence. Nous sommes particulièrement marqués quand Benjamin, presque sans nécessité, apporte à sa théorie de diffusion d’images, un complément d’argumentation épistémologique.

La nature du lien entre, d’un côté, l’exercice social de la souveraineté autocoercitive des masses et, de l’autre, l’épistémologie des sciences, relève de la « juridiction » d’une épistémè institutionnalisée, ou en phase de l’être. Ce serait alors, de nouveau, affaire de communication, de diffusion et de réception des idées scientifiques. Mais cette communication peut être pensée de deux manières différentes.

Au premier abord, on peut dire que la diffusion serait le facteur de l’affaiblissement épistémologique du contenu de la science. On observera qu’à l’issue du processus de socialisation, le résultat, au niveau du « produit » scientifique, s’imprègne du principe qui anime le milieu social qui en est le réceptacle. Les masses sont de nature statistique et la science, en se divulguant, change sa position épistémologique absolue et devient un jeu d’échantillonnage. Serait-ce là l’explication de la relativisation sociale de l’objectivité scientifique ?

L’analyse plus « objectiviste » révèle néanmoins, que les régimes respectifs des relations sociales et des contenus scientifiques seraient disjoints. La science se diffuse-t-elle en gardant son noyau épistémologique intact, au risque de ne pas pouvoir se diffuser au-delà d’un certain seuil d’intelligibilité sociale ? L’affaiblissement épistémologique est affaire de limites subjectives, éventuellement socialement motivées.

La conciliation de ces deux conceptions vient des intelligences que la science de la nature pourrait entretenir avec la science sociale. II y va du partage de la force épistémique entre les concepts sociaux et les concepts naturels. II y va donc de l’élucidation réelle des raccourcies scientistes imputables à la pensée philosophique de Benjamin.

Examinons la teneur épistémologique de la formulation « Ainsi se manifeste dans le domaine de la réceptivité ce qui déjà, dans le domaine de la théorie, fait l’importance toujours croissante de la statistique. » (Benjamin, 1991). D’abord, le « ce » de Benjamin est amodal et commun à tous les élans de l’esprit humain. C’est le « ce » de l’héritage mutualisé des poste-hégéliens, une sorte de supra-instance, une inclination du sens, en dehors des spécificités domaniales. Ce supra-domaine est le rapport du sujet à la réalité, l’affectation la plus primitive d’un être par ce qui n’est pas lui. Cette disposition générale que l’homme éprouve dans son rapport au monde, se traduit simultanément, selon Benjamin, sur l’ensemble des plans de l’implication présentielle et consciente de l’homme dans le monde. C’est pour nous faire sortir des considérations vagues, bien que pertinentes, que Benjamin introduit le terme concret de statistique. Mais qu’est alors la statistique dans notre rapport au monde, dans notre science, dans nos communications et nos manifestations artistiques ? Pour y répondre, nous avons besoin d’une doctrine de la contingence, c’est-à-dire d’une théorie de l’advenu, de la rencontre, de l’unique et du momentané, du particulier et du privatif. Remarquons, toutefois, que le fond opposé à toutes ces notions est le concept d’infini.

Le monde rendu infini, s’est détaché définitivement des sujets qui le pensent. Le concept d’infini est faramineux, comme l’était, dans les fondements scolastiques des croyances judéo-chrétiennes, le concept de Dieu Tout-puissant. C’est un concept qui consacre la cession de l’objet, son abandon en tant que partie de notre monde, de notre environnement. La pensée magique et cosmologique étendait le monde de l’homme bien au-delà de la perception sensorielle et offrait au sujet une prise quasiinfinie sur le réel, en participant au domaine couvert par ce que Benjamin appelle l’inconscient optique. Le grand défaut de cette prise a été son manque de précision et la pauvreté des concepts spécifiques qui en découlait. La science objective, au sens kantien, manipule les concepts plus riches qui portent donc sur des domaines plus restreints et démontent la naïveté des termes infinis non précis. Elle est plus proche de l’environnement humain et accuse même une tendance à se replier dans une nomenclature symbolique qui représente sans reste cet environnement. Pourtant, misant sur le versant empirique de ses épistémologies historiques, la science contemporaine multiplie ses concessions à l’objectivité et tend, à partir de statistiques des cas constatés, vers la probabilité théorique globale. Le monde est connu à travers l’environnement dont la pensée circonscrit les limites. On parle alors de l’ouverture de la pensée mais c’est, en réalité, du rafraîchissement des circonférences des pensables, à l’intérieur du domaine environnemental, qu’il s’agit. Les pensables, une fois renouvelés, restent délibérément à l’échelle des capacités cognitives, perceptives, théoriques et même imaginatives, du sujet humain. Le résultat est alors toujours frappé d’un certain finitisme, tandis que le mécanisme de rafraîchissement ne s’arrête pas. Le moteur de cette objectivation est le monde lui-même, à travers l’idée d’infinie. C’est donc à travers le concept de probabilité, dont les origines sont statistiques, que la science « adoucit » son épistémologie. Elle réadhère, tel un néo-mysticisme, à l’idée de totalité ouverte1 (Buci-Glucksmann, 2002), par la régulation de la pensée environnementale sur l’infinité du monde. Mais, si la magie rejoint la totalité en se référant aux fétiches précis qui n’ont que de vagues références au monde, la science procède avec ceux des représentants du monde qui garantissent des références précises. En même temps, pour ne pas se laisser scléroser dans le cercle environnemental, la science exerce une sorte de « veille épistémologique », à travers différents réductionnismes scientifiques. Son astuce consiste justement en ceci, que les objets sur lesquels elle a une prise par les opérations d’observation, de mesure ou de reconnaissance causale, les objets de l’environnement humain, tout en offrant des références précises au monde en tant que totalité, cèdent et abdiquent devant l’impérieuse force du monde en tant qu’Objet. De ce fait découle l’infinie interchangeabilité progressive, et pas forcement ascendante, des réductionnismes. La science place à la limite de sa visée un horizon, la frontière de notre environnement qui s’éloigne à mesure de son rapprochement, jusqu’à devenir le monde.

Le réel est infini non seulement par son étendue spatiale, en tant qu’Univers physique, mais par l’infinitude de ses attributs et de leurs caractéristiques. Nous parlons ainsi de l’inépuisable richesse du monde. L’infinité du monde réel est aussi une infinité originelle, c’est sur elle que se règlent les concepts mathématiques de l’infinité absolue. En revanche, ce que l’on appelle notre environnement, relève d’un autre concept de l’infini. L’infini du monde réel constitue le fond de l’infini de l’environnement. Dynamiquement, ce dernier est en posture de poursuite par rapport à ce premier. Alors que les moments et les paramètres du monde n’ont pas de référents précis, distinguables ou dénombrables, ils sont absolus, au sens qu’au-delà d’eux il n’y a proprement rien à rechercher, les unités de l’environnement adhèrent aux items du monde. L’environnement des êtres (si on prêtait à l’ensemble des choses la faculté d’être un soi par rapport à un non-soi, c’est-à-dire à un contexte, soit-il externe ou interne) et en particulier des êtres vivants, est indexable, d’une manière précise, dans les éléments formant le corps ouvert du monde. C’est ainsi qu’il nous arrive de stabiliser ou de refermer momentanément notre monde puisque le lieu de notre demeure n’est pas à proprement parler un monde mais un environnement. La notion de contingence exprime peut-être le mieux le sens de l’infini propre à l’environnement. Le contingent, lié à l’unicité momentanée et spatialement circonscrite de l’être (vivant), procure la référence précise à un ou des éléments du monde, – de cette relation découle le bénéfice de l’ouverture vers l’infini absolu. Le contingent qui inscrit l’être dans une situation donnée, tronque les référents possibles de l’être et l’enveloppe dans une séquence limitée de circonstances, – de cette relation découle le bénéfice de la stabilisation du monde. L’infinité précise et indexée est alors à l’origine de l’unicité. Est unique quelque chose qui, à la fois, puise dans l’infinité absolue du monde et opère dans cette infinité une identification, une sélection, non par le choix mais par la force d’occuper une position dans le site où elle se trouve. Quelle soit sédentaire et auto-concentrique ou qu’elle progresse sans repères fixes, dans une sorte de couloir à travers l’épaisseur du monde, la situation produit une stabilisation de l’environnement par rapport au monde. Autrement dit, la situation, le fait de faire établir un soi dans l’exercice des fonctions d’un sujet, en stabilisant le monde, crée l’environnement – l’union du monde infini et de la station.

L’infini de l’environnement est un infini de l’ouverture vers le monde, mais chaque ouverture advenue réellement conduit à une immobilisation, à une saisie, une demeure auprès des choses (cohaerere latin).

C’est ce dernier processus qui conduit à la typicalisation des objets. Comme l’exprime Petitot (Petitot, 2000), sur le terrain des relations entre le jugement et la perception : «[…] la perception singularise et permet d’individualiser alors que le jugement désingularise et typifie. ». L’action mémorielle du sujet n’est pas la même quand il s’agit du monde et quand il s’agit de l’environnement. Si c’est le monde qui est visé, le sujet enregistre son parcours perceptif à travers les différences distinguées, si c’est l’environnement qui est l’objet de l’attention, le sujet reconnaît ses objets, objets qui se répètent ou se ressemblent à travers des situations. La pluralité de situations débouche sur les types tandis que la visée du monde débouche sur la différence ultime. La différence est un concept mondain, le type est un concept environnemental. Les deux sont intimement consignés dans le concept d’item statistique.

L’expérience perceptive, en tant que rafraîchissement des données du monde, glisse sur les différences et s’attache aux types. Elle progresse autant qu’elle s’alourdit d’acquisitions. J.-F. Lyotard explicite, en 1971, dans Discours, figure, les principes de la perception en tant que tension entre type et différence : « Essayons de repérer la modalité de la différence dans l’espace perceptif. Le champ visuel fait l’objet d’une « correction », d’un aplatissement constant, qui visent à éliminer la différence et à homogénéiser l’espace en système d’oppositions. Pour l’animal qui parle, le traitement le plus spontané de l’espace perceptif, c’est l’écriture, c’est-à-dire l’abstraction. La spontanéité conduit à construire le champ comme un fragment de système qui « parle » par couleurs, lignes, valeurs. L’attention a pour fin de reconnaître. Reconnaître ne va pas sans comparer. L’oeil court ici et là, et compose sa toile familière. Par cette course qui consiste à la fois dans le balayage du champ et dans l’accommodation de l’appareil optique, chaque partie est tour à tour placée au foyer, identifiée en vision centrale et ordonnée aux autres dans une composition de part en part intelligible, qui est euclidienne. L’attention écrit l’espace ; elle y trace des lignes, des triangles ; les couleurs pour elle sont comme des phonèmes, unités valant par opposition et non par motivation. » (Lyotard, 1971). On verra les détails de cette ébauche du programme cognitiviste fonctionner dans les simulations pratiquées par les sciences cognitives.

C’est précisément à la jonction de l’infini mondain et de la sélectivité environnementale que se situe la contingence porteuse de l’aura des choses. L’Objet kantien et la statistique en tant qu’elle est le concept co-axial des sciences de la nature et des sciences de la société, préparent la nouvelle intelligibilité de l’objet sui generis. Nous nous trouvons dans une situation épistémique à sens unique, où le retour pur et simple à la conscience magique serait, ou plutôt est, une démission intellectuelle, avec laquelle on flirte, certes, mais avec laquelle, raisonnablement, on ne se marie pas. Nous sommes alors obligés de suivre les vicissitudes de l’aura, analyser le phénomène de son actuelle déchéance qui avait ses raisons propres, annoncées par Benjamin, en 1935, et qui continue à en avoir, non sous une forme changée mais plutôt d’une manière évoluée, à partir de la nouvelle révolution technique qui est l’invention de l’informatique, accomplie aux alentours de l’année de la mort de l’écrivain.

Tout d’abord, de quoi, précisément, parle Benjamin dans l’exemple heuristique qu’il donne de l’« apparition unique d’un lointain, si proche soit-il » ? La figure de la présence inatteignable recèle un fond philosophique largement discuté depuis la première décade du 20ème siècle. La dialectique du proche et du lointain n’a rien d’une banalité. Elle réalise le lien intime qu’ont, dans la perception, l’immanence et la transcendance. Merleau-Ponty dit ceci de ce paradoxe :«[…] si nous réfléchissons sur cette notion de perspective, si nous reproduisons en pensée l’expérience perspective, nous verrons que l’évidence propre du perçu, l’apparition de « quelque chose » exige indivisiblement cette présence et cette absence. » (Merleau-Ponty, 1947). Le croquis minimaliste que Benjamin fait, enferme une situation, du point de vue cognitif, très complexe. L’homme suit du regard la montagne et l’arbre qui jette sur lui son ombre. Sur les deux plans, dont il est le centre, il suit respectivement le profil d’un horizon et la ligne d’une branche. Le regard qui en tant que sens distant, aussi rapproché soit-il, est un médium de distance, c’est-à-dire un médium à transformation projective de l’information, organise la projection qui permettra de prélever l’information cognitivement exploitable. Cette dernière s’agence différemment quand il s’agit de la figure (ligne) et quand il s’agit du fond (horizon )2 (Simonis, 2001). C’est une scène spatiale à plusieurs épaisseurs et avec un cadre temporel dynamique. La singularité de la trame de temps et d’espace est la condition de l’apparition de l’objet. C’est aussi l’espace de résolution du problème pratique fondamental, dont la philosophie des sensations, depuis la Grèce Antique jusqu’à nos jours, en passant par toutes les époques, distingue la signification et la difficulté capitale, le problème du hiatus entre la limitation ponctuelle et momentanée de notre position spatio-temporelle et la plénitude de l’être en tant que connaissable. S’il est encore impossible de parler, autrement qu’en termes flous, des singularités du temps, si le temps n’est pas quelque chose de manipulable autrement qu’à l’échelle subjective3, au sens banal, la dimension spatiale de la perception, et notamment de la perception visuelle, est l’objet des recherches concluantes, depuis les travaux pionniers de David Marr, dans les années 1970 (Marr, 1982). On sait, que l’information utile sur l’objet volumique se recueille à partir des singularités mathématiques de la fonction de luminosité sur la ligne du contour apparent de l’objet projeté sur la rétine. Une branche offrant son ombre en est un cas simple et exemplaire, l’horizon montagnard étant plus compliqué puisque l’apparition d’une chaîne de montagnes résulte d’une projection secondaire de plusieurs contours apparents se trouvant à des distances différentes de l’observateur.

En quelque sorte, la branche nous impose son temps par la pérégrination de son ombre, et nous, nous imposons notre temps perceptif en déambulant sur la crête de plusieurs montagnes alignées par la projection.

En dialecticien, Benjamin distingue alors plusieurs périodes de la perception considérée comme mécanisme objectif, comme instrument de possession du monde par distanciation. Sur le terrain social, cet aboutissement stabilisé de l’évolution biologique, ne cesse, en effet, d’évoluer et de fluctuer. Tout d’abord, dans le travail d’enrichissements souterrains, la réceptivité subit le retour du milieu humain, de cet artifice auquel elle a contribué grandement. A force de fabriquer ce milieu, les techniques successives apposent à la réceptivité leurs contraintes directionnelles. La production et la reproduction sont ainsi intimement attachées à la cognition. Les techniques deviennent interprétables en termes de solution des rapports dans le couple, massifié, du sujet et de l’objet. C’est la période moderne, la pratique simultanée de la peinture, de la photographie et du cinéma, qui est le théâtre de ces processus historiques. C’est aussi le moment de l’émancipation de l’art en dehors des moyens de production de la culture. Dans le cas de ces derniers, l’aura est irrémédiablement déchue. Ils s’objectivent dans leur institutionnalisation et deviennent instruments de répression. C’est là, également, par le fait de la conservation de la propriété par l’état totalitaire, qu’advient le processus d’esthétisation de la politique qui culmine dans la guerre, dans la destruction du corps social. L’art seul garde sa réactivité et il peut répondre à l’esthétisation de la politique par sa propre politisation. Sur le terrain de l’art, la question de l’aura reste ouverte, sauf dans l’univers de l’art-marchandise où elle se réduit à l’épreuve de l’original et de la copie, et ne concerne plus que les commissaires priseurs. Sur le terrain des moyens de diffusion, tels les journaux illustrés, la photographie publicitaire ou la signalétique graphique, l’aura est irréparablement trahie.

Le dernier épisode de cette dialectique s’est déroulé devant les yeux de Benjamin. « Seule la guerre permet de mobiliser la totalité des moyens techniques de l’époque actuelle en maintenant les conditions de propriété. » Ce qui fut fait. Suite à la formidable mobilisation des mathématiciens, des logiciens, des linguistes, des physiciens, des biologistes, et d’autres, tous affectés de près ou de loin au génie militaire, la machine à simuler le système nerveux et les contrôles qu’il peut exercer sur les différents aspects du réel, a vu le jour. Le programme intellectuel et pragmatique de la première cybernétique atteint, encore assez naïvement, l’objectif de la recréation de l’intelligence humaine. « L’intelligence humaine demeure toujours très éloignée de l’intelligence divine qui embrasse tout ; de même l’intelligence du Golem [lire : ordinateur] est très en-dessous de l’intelligence humaine, il lui manque cette spontanéité qui, seule, fait que l’homme est ce qu’il est. Cependant, même à son niveau infra-humain, le Golem est une figuration du pouvoir créateur de l’homme. » dit Scholem (Scholem, 1974), avant d’évoquer la lignée spirituelle de Johann von Neumann et de Norbert Wiener.

Quant à la culture et à l’art, jusqu’à une époque très récente, l’informatisation des métiers artistiques atteignait principalement la dimension de simulation des outils de production traditionnels. Mais en plongeant les arts post-avant-gardistes dans un nouveau système technique (numérisation-convergence des supports), dans une nouvelle économie (mondialisation) et, depuis la fin des années 1970, dans un nouveau modèle de communication (réseau), l’informatique demande à réinterroger justement la question de l’aura. La dialectique de l’aura est aujourd’hui, de nouveau possible. On peut trouver ici le même clivage qu’à l’époque moderne. En se déplaçant depuis les conditions de production vers les conditions de réception, on voit deux processus pratiquement symétriques. D’un côté, avec la possibilité accrue de reproduction des codes numériques, la question de l’aura est définitivement close. D’un autre côté, on entrevoit plusieurs ouvertures qui laissent la question en suspens, et donc aptes à devenir un enjeu politique, une scène encore instable, sujette aux actions et non au déterminisme techniciste. Les ouvertures qui se dessinent aujourd’hui portent sur le rapport que le récepteur pourrait avoir à l’objet d’art. Plusieurs types d’interaction sont envisageables. Maignien (Maignien, 1996) en analyse un large éventail, mais en se cantonnant à la valeur « médiatique » du réseau numérique. Le langage (code) et la logistique du système numérique distribué ordonnent le vecteur du jeu d’interprétations qu’effectuera l’instance de réception publique. Rieusset-Lemarié apporte quelques hypothèses semblables (Rieusset-Lemarié, 1998).

Or, pour Couchot, le travail accompli dans cette sphère de nouvelle réceptivité de l’oeuvre aménage la valeur créative même de cette oeuvre, et la fait progresser sur une pente ascendante de classement de modèles d’inspiration :«[…] tandis que la première interactivité s’intéressait aux interactions entre l’ordinateur et l’homme sur le modèle stimulus-réponse ou action-réaction, la seconde interactivité s’intéresse davantage à l’action en tant qu’elle est guidée par la perception (I »‘énaction »), à la corporéité et aux processus sensori-moteurs, à l’autonomie (mais on dira aussi plus précisément I »‘autopoïèse », concept que l’on doit au neurobiologiste Francisco J. Varela). Aux modèles physiques de la première s’opposent et/ou s’ajoutent les modèles issus des sciences cognitives ou des sciences du vivant. » (Couchot, 2003). Reconnaître ce qui donne sens à cette dernière affirmation, c’est rejoindre ce qui semble être l’ultime et le plus complet édifice théorique d’une vision « additionnelle » du rapprochement entre l’art et la technologie. Le rapprochement en question s’accomplit, pour l’art, à partir des opérations heuristiques qui lui sont propres. Il s’agit, d’un côté, de l’aboutissement créatif à l’oeuvre finale, et d’un autre côté, du dévoilement spectatoriel de l’oeuvre, par différents modes de sa donation, allant depuis celui du couple oeuvre/spectateur immobiles, jusqu’aux scénarios interactifs et ouverts de l’oeuvre fluctuant sous les impulsions externes et internes. C’est la conséquence directe de la pensée de création et de réception, forgée par les avancées théoriques et expérimentales des écoles de Berlyne, de Francès et de Moles, et revalorisée à la lumière des technologies numériques actuelles. Mais si les modèles scientifiques de la perception et de la cognition devaient s’appliquer aux relations, productrice et réceptrice, à l’œuvre, l’artiste ne saurait que les côtoyer, avec plus ou mois de compétences personnelles. Tout change du moment où ces mêmes modèles coexistent avec la démarche de l’artiste et de son partenaire social. La démarche qui se tient à l’endroit-même de l’exercice de la perception et de la cognition produit directement des méthodes participatives, non d’une oeuvre maisd’un monde qui se déploie de notre milieu vers l’univers. Ici, l’artiste, qui éventuellement accuse une tendance à penser explicitement par modèles et par simulations, n’aménage pas, tel un scénographe, l’accès à sa production, mais il progresse sur la voie d’un autre statut de la réceptivité dans l’art. La jouissance du statut inhérent de la réceptivité assure à l’agent esthétique sa place de concepteur et d’expérimentateur de modèles, et ceci à partir d’une position intime, c’est-à-dire propre, subjective et originale. Dans cette situation, il n’y a plus lieu de parler des relations science-art, puisque les deux n’ont plus à échanger leurs légitimités respectives : ils concourent à croiser leurs visées cognitivistes. Au lieu de leurs intelligences historiques, on peut parler d’une union structurelle, de l’épistémologie et de la praxie.

Si cette cohérence de deux grands flots d’énergies spirituelles de l’humain présente le trait de généricité, il n’en est pas moins que l’histoire leur donne des impulsions conjoncturelles. Ainsi, depuis l’époque benjaminienne, ce n’est pas l’aura qui est déchue, mais c’est l’oeuvre comme condition indispensable de l’expérience artistique qui est déposée – et en son absence, il n’y a plus lieu de parler de l’aura. L’art est un procédé soutenu de perceptibilité, dans son essence-même, et en tant que tel il n’est peut pas être producteur d’objets (de représentants du monde). L’art est un rapport au monde et n’offre guère de terminaux auxquels s’attacher. L’objet d’art accomplit le mystère du fait que l’instance subjective, dont l’identité est à la fois stable et historicisée, assume cognitivement la versatilité du flux incessant de la donnée – l’objet d’art est un sujet. Il l’était toujours à la manière de l’inconscient optique, et l’époque dont Benjamin a été le témoin l’a tiré de cet inconscient au grand jour de l’esthétique politisée. L’art de la plus récente révolution technique ne saura pas être la véritable réceptivité s’il ne renoue pas avec ce qui a été le projet le plus intime de l’informatique : la reproduction du rapport du subjectif à l’objectif, de la condition de l’unique à l’ouverture de l’universel.

Cet art est autant une science. Non seulement parce que la technologie participe du contrat de mutuelle stimulation de la technique et de la science, mais aussi et avant tout parce qu’elle institue des relations perceptives précises. Si on bascule du précis scientifique vers le singulier artistique, c’est de l’aura-même que l’on parle ; non de l’aura de l’couvre, mais de l’aura à l’couvre. Ce fait constitue l’apport inédit et original de cet art à l’histoire. Inversement, si à travers du singulier de l’art on envisage d’appréhender le précis de la science, en surpassant les anciennes craintes de détermination apodictique, on rencontre une science cognitiviste, adaptée au traitement de l’entremise mondaine de l’être sensible, une science dont l’objectivité, et c’est une première dans l’histoire de l’épistémologie, est réglée sur la condition subjectale4.

Les exemples de cette osmose intime de l’art et de la science manquent ou plutôt, en tant que processus, ils sont disséminés dans des réalisations partielles, et il est aujourd’hui extrêmement délicat de les chosifier en les déferant sur la place publique de la critique d’art qualifiante. La difficulté de les exposer est irréductible. Ce ne sont pas des works in progress mais des situations organisant une progression de la sensibilité à travers le monde : des dispositifs processuels dans leur fonctionnement et, en conséquence, instables dans leur façon d’agir. Il est aussi bien de les suivre à partir de certains faits artistiques qu’à partir d’agissements qui ne se réclament pas de l’art. En effet, l’expérience esthétique de ce type est aujourd’hui vécue dans les laboratoires de la sensorialité artificielle, surtout ceux de la vision. Le temps est venu que l’esthétique, elle aussi fasse sienne la formule de L’oeil et l’Esprit de Merleau-Ponty : « Il faut prendre à la lettre ce que nous enseigne la vision » (Merleau-Ponty, 1964). Qui pourrait mieux que les inventeurs de la rétine artificielle ou des systèmes experts de reconnaissance d’objets et de personnes, affirmer aujourd’hui que l’esthétique, d’après la leçon de son fondateur, Alexandre Gottlieb Baumgarten, est la connaissance sensible (sinnliche Erkenntnis).

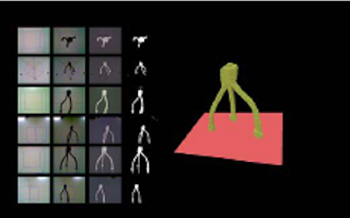

Essayons d’apercevoir ce principe dans les objectifs déclarés de la réalisation EyeBox de Simon Greenwold d’Aesthetics and Computation group au MIT Media Lab, qui trente ans plus tard, répondent en détail (voir les précisions sur le site de MIT (Greenwold, 1995)) au programme procédural tracé par Lyotard : différence / type, extraction de l’information pertinente à partir des couleurs, contours / plages chromatiques, discrimination / identification, reconnaissance et comparaison, balayage du champ et accommodation, vision centrale et ordonnancement euclidien de l’espace visuel.

« EyeBox is a component technology in a larger project under development called The Associate, which aims to use physical objects instead of names as referents for digital information. You place an object from your environment into The Associate (a box much like EyeBox). The object is quickly scanned and matched against other objects that have been placed in before. If the object is new, you are prompted to pull on top of it any set of files or information that you want to permanently associate with it.

The problem that EyeBox solves is the recognition problem that The Associate poses: How can we quickly recognize any object that you place into the system regardless of its orientation, having seen it perhaps only once before from a diffèrent angle? We know that objects look radically diffèrent from diffèrent viewpoints. We need some invariant property to use for recognition. Options include, color, mass, spatial moments, or volume envelope. EyeBox uses quickly computed spatial properties of the object’s volume for recognition. […]

I tested the similarity of two volume signatures by comparing them with a Euclidean distance norm. I would, however, iterate, shifting the comparison over by one value at a time to find the least distance for two signatures because if the object was in a diffèrent orientation I expected the volume histogram to be arbitrarily translated. » [13]

Réflexions sur l’art « objectal », à l’époque de sa conquête de l’informatique

Il existe plusieurs métaphores de l’intelligibilité de l’informatique dans le domaine de l’art.

La métaphore mécano-computationnelle correspond à la refonte des anciennes techniques de représentation sur le fond de l’unification du format des différents supports. La dynamique de la machine informatique épouse ici les dynamiques inhérentes aux supports traditionnels, les stimule et les étend au-delà de certaines limites, circonscrites d’ailleurs, pour la plupart, par les expérimentations des mouvements avant-gardistes de la première moitié du 20ème siècle. Des transformateurs et des générateurs d’images et de sons font partie de ce type d’usage artistique de l’ordinateur. Mais on n’y dénombre aussi les générateurs d’espaces sonores, de formes graphiques et d’objets volumiques, de vidéo et d’univers virtuels. Dans le domaine des arts du langage, l’informatique procure le support et les générateurs d’hypertextes.

La métaphore communicationnelle replace les productions numérisées ou celles dont la conception à été assistée par l’ordinateur, dans le contexte de la communication réseautique. Ici, on rejoue les expériences du mail art, de l’esthétique de la communication ou de l’art relationnel, dans le cadre politique et éthique de l’émergence d’une intelligence collective et distribuée des réseaux numériques.

La métaphore robotique semble couronner cet édifice du nouveau système des beaux-arts, puisque sans se désister des avantages des précédentes elle achève et parfait la conception objectale de l’oeuvre d’art dans la civilisation occidentale. L’oeuvre qui devient un scénario ou encore un programme génératif et évolutif de l’interaction avec son milieu d’accueil et de réception étend, explicite, dynamise et agence les circonstances de sa production, de son être et de la production de son sens. En tant qu’entreprise d’usinage de nouveau type, l’informatique a su se rendre solidaire des processus collaboratifs et duratifs de la genèse de l’oeuvre. En tant qu’outil de connaissance, c’est-à-dire technique de mémorisation et de calcul logique, le principe de son rapport au réel, la simulation, a épousé et stimulé les caractères de l’éphémère, de l’ubiquité et de l’instabilité de l’oeuvre d’art. Dans sa dimension créative, l’informatique a consacré, finalement, l’émancipation homéostatique et l’autonomie quasi-morale de l’oeuvre, qui s’engage en tant qu’agent dans l’expérience de l’interactivité herméneutiquement ouverte.

L’oeuvre fluctuant et évoluant, échangeant avec les individus et avec le tissu social, est un Super-Objet qui incarne et chosifie le plus ancien rêve de l’esthétique occidentale – celui de la véracité atteinte dans le processus de complétion des attributs objectaux.

Rappelons nous de la pensée platonicienne. L’oeuvre d’art de la Grèce Antique est un objet, un vrai objet, tellement vrai que vivant. Le peintre et le poète sont exclus de ce système des beaux-arts. Le premier, par son incomplétude, de par le caractère partiel de sa réceptivité, et en conséquence, de sa production, le seconde, à cause de son attitude irréductiblement non-objective. Le programme du rendement réaliste dans la représentation et le postulat de l’objectivation scientiste, ainsi que la répression des attitudes contraires, sont inscrits dans le premier traité de la politique esthétique, la République.

Si on replaçait cette discussion dans notre situation contemporaine, il faudrait relever la différence philosophique entre, d’une part l’idée de l’autonomie autoapprenante et évolutive, et d’une autre part l’exercice souverain de l’expérience cognitive à visée limitée et radicalement subjective. Les avantages de la première position sont évidents. Mais quel gain gnosique peut-on escompter en affirmant la limitation et la localisation subjective de la connaissance ? Rien d’autre que la sauvegarde du caractère expérientielle de toute intramise mondaine. Certes, on perd la force de l’objet qui résiste du haut de son homéostasie de complexité et de complétude, on perd la rationalité sociale de l’intelligence collective (des insectes), mais à la place de cela, à la place de la véracité, on renoue avec la possibilité de vérification gnosique de tous les sens d’être établis. La limitation de la visée et l’unicité de la propre situation du sujet, sont les caractéristiques essentielles de toute action gnosique et en tant que telles elles sont le mécanisme local le plus à même de garantir au vivant, au niveau individuel et au niveau de populations, la fabrication des homéostasies non seulement interactives, mais réellement adaptatives. C’est de l’adaptation universelle, pardessus des générations, mais éprouvée à la dimension de la sphère intime, qu’il s’agit. Ce n’est pas une fatalité ou une vulnérabilité, c’est un principe protensionnel.

Si l’informatique devait prendre part dans la connaissance sensible, elle doit se réapproprier sa première vocation cybernétique d’être une technique de contrôle du milieu. Sa métaphore la plus puissante est celle du système nerveux et c’est en tant que telle que l’informatique peut participer à la vocation politique de l’art de ne pas être un objet mais être un sujet.

La conception objectale de l’oeuvre d’art a provoqué, à l’époque des avant-gardes, une farouche réaction révolutionnaire visant à de-chosifier la production artistique par la remise en question de sa matérialité et de sa dimension représentationnelle. L’époque post-moderne a instauré, à l’endroit de l’oeuvre déposée, l’objectivation des processus créatifs, communicationnels et interprétatifs.

La conquête de la techno-science et de la techno-culture informatique par les artistes, depuis le computer-art, les environnements immersifs, jusqu’au web-art et la vie artificielle, est un processus parallèle aux deux précédents. Pourtant, sa signification politique est loin d’être définitivement fixée.

Les adversaires et les partisans de l’art numérique citent souvent Paule Valéry et Walter Benjamin. Les premiers pour avertir de l’ubiquité dématérialisante et de la fin de l’oeuvre propre et originale, les seconds pour affirmer que les attributs non-triviaux, communicationnels, interactifs, hybrides et polysémiques de l’oeuvre numérique, procurent à cette oeuvre le caractère auratique, perdu par l’époque de reproductibilité mécanique.

Ou bien, l’aura en tant qu’accompagnement de l’objet-substitut authentifié par l’informatique réputée non standard, ou bien, l’action du sujet sensible à travers le monde auratique de la poursuite respectueuse de l’infini – tel est l’enjeu de la question de l’art qui s’avise à investir les potentialités théoriques et pratiques de l’informatique. C’est, d’ailleurs, l’informatique elle-même qui suggère la réponse. Non l’informatique du système technique ou celle du montage social du consensus de fabrication d’usages massifs, mais le domaine de la « réflexion pratique pure ». Depuis son programme original, elle se voulait une technique dressant la richesse sémantique limitée des algèbres en face d’une infinie richesse du monde. Sa visée et son problème fondateur sont alors analogues à ceux du peintre de Merleau-Ponty : le modélisable et le simulable de l’informatique sont à l’image du perceptible d’un peintre qui possède uniquement un « monde visible, rien que visible, un monde presque fou, puisqu’il est complet n’étant cependant que partiel »5 [12].

L’informatique se voulait bio-inspirée et en tant que telle elle a inscrit en elle le principe évolutif de réactivité. Ce programme, sans se prévaloir, pour l’instant, des résultats décisifs et sans pouvoir s’imposer dans l’économie mondiale de la recherche, est en train de se réaliser dans des laboratoires des sensorialités artificielles où s’élabore la naturalisation du phénomène originel de la conscience. Ses moments philosophiques les plus forts sont : les simulations progressives et écologiques des mécanismes biologiques de contrôle, l’introduction des logiques floues et des opérations sémantiques, le dépassement des traducteurs numériques au profit des solutions analogiques, et finalement l’horizon de l’informatique de particules élémentaires et de tissus vivants. Si, alors, une discipline technoscientifique est obligée aujourd’hui de prendre en son sein des décisions politiques pour opérer ce tournant encore hautement incertain, il n’est pas étonnant que l’art soit confronté à ce genre de choix avec d’autant plus d’acuité.

On a pourtant l’impression que la plupart des réalisations artistiques convaincantes sont des tentatives de rattraper le progrès scientifique afin de pourvoir les oeuvres des caractéristiques « humaines » (human factor)… Nous faut-il rappeler que l’humain est humain non par sa capacité d’interagir, mais par sa position d’être un champ sensible coexistant avec le monde, un moment de bascule de la manifestation de l’être vers la réceptivité, à une étape précise et toujours à dépasser de l’Évolution Universelle ?

Notes

[1] La discussion récente des principaux thèmes benjaminiens ainsi que de la notion d’ouvert chez Rilke est proposée par Christine Buci-Glucksmann [2].

[2] Les liens entre Benjamin et la gestalt-théorie sont discutés récemment par Annette Simonis [6].

[3] Comme cela est le cas dans la Machine à renverser le temps de Pierre Kowalski, exposée en 1996 à la Biennale de Lyon.

[4] Qu’il faudra développer, en termes philosophiques, ceci n’est pas un enseignement du sujet ou de la subjectivité consciente absolue mais de l’unicité sensitive universelle.

[5] Maurice Merleau-Ponty, 1964a, L’œil et l’esprit, Gallimard, Paris [12].

Bibliographie

– Benjamin, Walter, « L’oeuvre d’art à l’époque de sa reproduction mécanisée » dans Walter Benjamin, Ecrits français, Paris, Gallimard, 1991 [1936], 400 p.

– Buci-Glucksmann, Christine, La folie du voir. Une esthétique du virtuel, Paris, Galilée, 2002, 280 p.

– Couchot, Edmond et Norbert Hillaire, L’art numérique. Comment la technologie vient au monde de l’art, Paris, Flammarion, 2003, 288 p.

– Greenwold, Simon, Spatial Computing, Thesis of Master, MIT, 1995.

– Lyotard, Jean-François, Discours, figure, Paris, Klincksieck, 1971, 461 p.

– Maignien, Yannick, « L’oeuvre d’art à l’époque de sa reproduction numérisée », Bulletin de la Bibliothèque nationale de France, vol. 41, n° 1, Paris, 1996, p. 16-24.

– Marr, David, Vision. A Computational Investigation into the Human Representation and Processing of Visual Information, W.H. Freeman, 1982.

– Merleau-Ponty, Maurice, L’oeil et l’Esprit , Paris, Gallimard, 1964, cité dans Charles Daniel, « Esthétique – L’expérience esthétique », l’Encyclopxdia Universalis, 1995.

– Merleau-Ponty, Maurice, « Le primat de la perception et ses conséquences philosophiques », Bulletin de la Société française de Philosophie, tome XLI, n° 4, 1947, p. 119-135.

– Petitot, Jean, « Les nervures du marbre. Remarques sur le « socle dur de l’être » chez Umberto Eco », dans Jean Petitot et Paolo Fabbri, Au nom du sens. Autour de l’couvre d’Umberto Eco, Paris, Grasset, 2000, p. 83-102.

– Rieusset-Lemarié, Isabelle, « L’unicité de l’oeuvre à l’épreuve de la reproduction multimédia » dans les actes du colloque Le concept de Rupture dans les couvres produites par les Nouvelles Technologies, 7 mars 1998, Paris-7 Denis Diderot.

– Scholem, Gershom G., Le Messianisme juif. Essais sur la spiritualité du judaïsme, Paris, Calmann-Lévy, 1974, p. 471-478.

– Simonis, Annette, Gestalttheorie von Goethe bis Benjamin, Bôhlau, 2001.